最近“即梦”上线了数字人1.5模型,刚推出就火遍AI圈!

我第一时间上手实测,一起来看看它到底有多强。

先来看官方介绍:

说人话就是:现在什么图都能对口型了!

不仅可以精准同步语音,还能自定义动作和镜头语言,彻底告别以前“只有嘴巴动、身体像木头”的尴尬画面。

更惊喜的是,它还支持双人对口型,不用再手动用剪映切蒙版那么麻烦了!

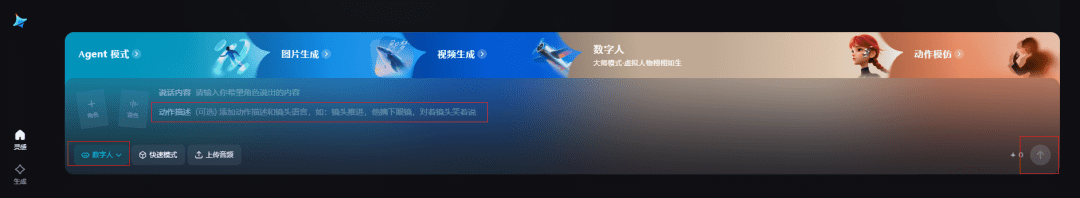

怎么用?超简单!

打开即梦,切换到“数字人”功能,能看到新增的“动作描述”框。

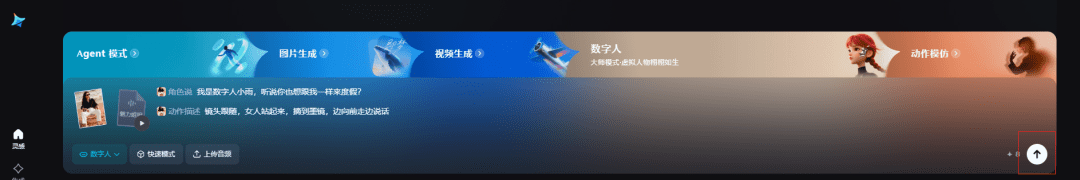

1. 单人对口型实测

先试一个单人画面,输入动作描述:“站起来,摘掉墨镜,一边向前走一边说话”。

效果非常自然!人物真的会起身、摘墨镜、走路,而不是呆呆地只动嘴。

2. 萌宠也能对口型?

之前很多小伙伴反映动物类图片对口型基本失败,这次我也试了试。

什么提示词都没写,完全交给AI自由发挥,结果口型居然很同步!

3. 机甲类形象测试

机甲这类非人脸特征明显的角色,过去经常识别不了。

这次输入“边走边说话”试试。

动作幅度虽然不大,但至少能准确识别面部区域并同步语音了,进步很明显!

如果完全不写动作描述呢?

我也试了,口型是准的,但身体比较静态。

所以建议大家还是适当加一些动作词,效果会更生动。

4. 动漫角色:海绵宝宝

连卡通形象也驾驭得很自然,说话时的表情和肢体细节都很到位。

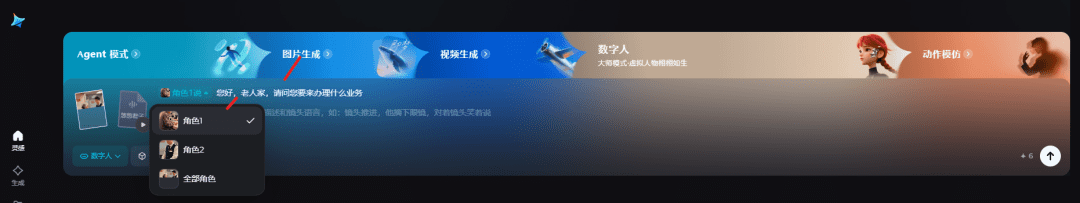

5.双人对话场景实测

多人画面中,系统会自动识别出不同人物,你可以指定谁来说话。

不说话的人也会有自然的小动作,整体观感非常流畅。

侧脸或背对镜头也能识别?

比如这位老奶奶,几乎是背对镜头的。

放在以前根本识别不了,现在居然也能对上口型,必须点赞!

我的小贴士

动作描述建议具体,比如“转身挥手”“边走边笑”,效果更生动;

双人画面最好指定发言者,避免AI自动分配不如预期;

复杂形象(机甲、卡通等)可以多试几次,抽卡也是一种乐趣。

更多详细操作可以参考官方文档:https://bytedance.larkoffice.com/wiki/FEGqwYdCMi89qWkV2bpcdG3On9b

即梦这波更新确实让人眼前一亮。

技术门槛正在不断降低,我们要做的反而是回归创意本身。

理解工具逻辑,大胆尝试不同场景。

等到技术彻底普及那天,拼的就是谁的想象力更独特。

怎么样,你学会了吗?

相关资料获取:扫一扫添加微信关注我!

琼ICP备2024040541号-2

琼ICP备2024040541号-2